📌 Por qué los grandes modelos fallan cuando se olvidan de lo más importante: los datos y su estructura.

Introducción

En la era de la inteligencia artificial (IA) generativa, del aprendizaje automático y de los Large Language Models (LLMs), muchas empresas invierten millones en modelado sin detenerse a revisar una pregunta crítica: ¿están sus datos preparados para esto?

La mayoría de los proyectos de IA no fallan por el algoritmo. Fallan por una arquitectura de datos débil. Este artículo explora por qué la arquitectura de datos es el verdadero factor diferencial entre modelos funcionales y promesas incumplidas.

¿Qué es la arquitectura de datos y por qué importa en IA?

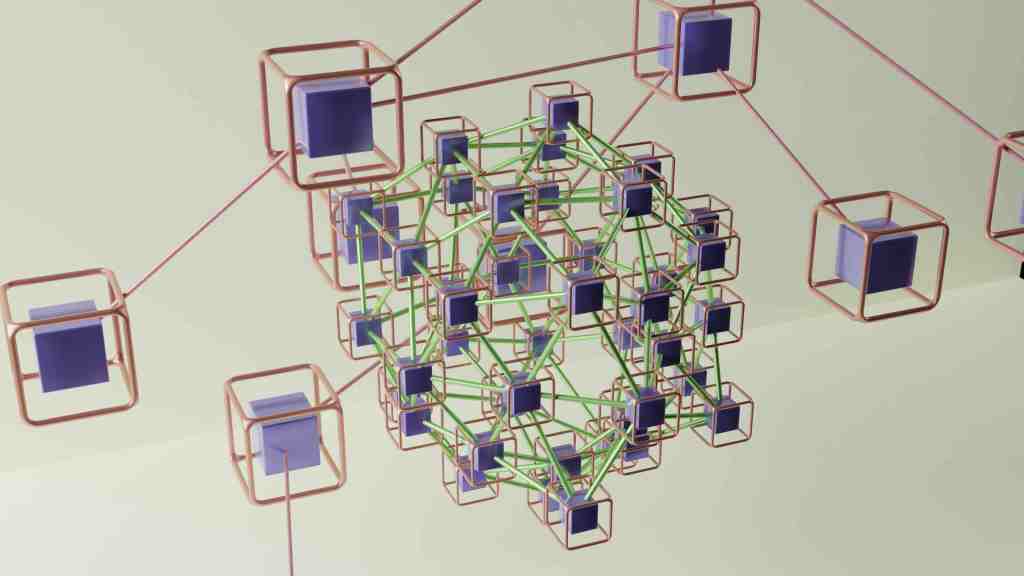

La arquitectura de datos es el diseño estratégico que define cómo se capturan, almacenan, transforman, gobiernan y acceden los datos dentro de una organización.

Cuando hablamos de inteligencia artificial, la arquitectura de datos:

- Asegura la calidad y trazabilidad de los datos.

- Permite que los modelos consuman datos confiables, consistentes y actualizados.

- Facilita el escalado de soluciones de IA desde el laboratorio a producción.

💡 Un modelo de IA entrenado con datos inconsistentes es como una nave espacial con combustible contaminado.

El mito del «más datos = mejores modelos»

Uno de los errores más comunes en las organizaciones es creer que más datos automáticamente generan modelos más inteligentes.

Lo real:

- Datos duplicados, sin contexto o sin gobernanza → modelos sesgados o ineficientes.

- Datos en silos → limitan la capacidad de generalización del modelo.

- Pipelines no auditables → dificultan la trazabilidad y el compliance.

Una buena arquitectura de datos:

- Elimina el data swamp.

- Establece control de versiones, linaje y calidad.

- Define capas: raw, curated, feature store, inference-ready.

Arquitectura de datos moderna para IA: componentes clave

- Ingesta escalable y gobernada

– Streaming + batch + control de calidad. - Modelos de datos bien definidos (semánticos y físicos)

– Evita ambigüedades, mejora performance. - Catalogación, linaje y metadata activa

– No se puede usar lo que no se conoce. - Pipelines orquestados y versionados

– Airflow, dbt, Prefect, Dagster. - Data Lakehouse / Data Mesh / Data Fabric

– Arquitecturas flexibles y centradas en dominio. - Feature Store compartida

– Reutilización de variables, consistencia entre entrenamiento e inferencia.

¿Qué pasa cuando no hay buena arquitectura?

- Data scientists que dedican el 70-80% del tiempo limpiando datos.

- Modelos que funcionan en Jupyter Notebook, pero fallan en producción.

- Dificultades para explicar decisiones algorítmicas en auditorías.

- Retrasos en proyectos críticos por falta de datos confiables.

Casos reales (sin nombres, con lecciones)

- Caso A: Una startup de fintech entrenó un modelo de scoring sobre un dataset desactualizado y sin control de versiones. Resultado: riesgo elevado y decisiones erróneas.

- Caso B: Una empresa retail centralizó sus datos en un Lakehouse con capas bien definidas, usando Snowflake y dbt. Resultado: aceleró la entrega de modelos y mejoró la colaboración entre datos y negocio.

✅ Buenas prácticas para arquitectos de datos que trabajan con IA

- Diseñá con la inferencia en mente desde el principio.

- Hacelo reproducible: pipelines versionados + control de datos.

- Involucrá a los equipos de datos desde la definición del caso de negocio.

- Pensá en gobierno, no solo en performance.

- Automatizá pruebas y validaciones de calidad de datos (Data Observability).

📈 Conclusión: la IA no es magia, es arquitectura

Los mejores modelos de IA no empiezan con algoritmos, sino con una arquitectura de datos sólida, flexible y diseñada para escalar.

👉 Si la IA es el cerebro, los datos son la sangre. Y la arquitectura de datos es el sistema circulatorio.